Ten Lessons from the Milgram Studies: Creating Evil Traps for Good People

Let’s outline some of the procedures in this research paradigm that seduced many ordinary citizens to engage in this apparently harmful behavior. In doing so, I want to draw parallels to compliance strategies used by “influence professionals” in real-world settings, such as salespeople, cult and military recruiters, media advertisers, and others .There are ten methods we can extract from Milgram’s paradigm for this purpose:

- Prearranging some form of contractual obligation, verbal or written, to control the individual’s behavior in pseudolegal fashion. (In Milgram’s experiment, this was done by publicly agreeing to accept the tasks and the procedures.)

- Giving participants meaningful roles to play (“teacher,” “learner”) that carry with them previously learned positive values and automatically activate response scripts.

- Presenting basic rules to be followed that seem to make sense before their actual use but can then be used arbitrarily and impersonally to justify mindless compliance. Also, systems control people by making their rules vague and changing them as necessary but insisting that “rules are rules” and thus must be followed (as the researcher in the lab coat did in Milgram’s experiment or the SPE guards did to force prisoner Clay-416 to eat the sausages).

- Altering the semantics of the act, the actor, and the action (from “hurting victims” to “helping the experimenter,” punishing the former for the lofty goal of scientific discovery)—replacing unpleasant reality with desirable rhetoric, gilding the frame so that the real picture is disguised. (We can see the same semantic framing at work in advertising, where, for example, bad-tasting mouthwash is framed as good for you because it kills germs and tastes like medicine is expected to taste.)

- Creating opportunities for the diffusion of responsibility or abdication of responsibility for negative outcomes; others will be responsible, or the actor won’t be held liable. (In Milgram’s experiment, the authority figure said, when questioned by any “teacher,” that he would take responsibility for anything that happened to the “learner.”)

- Starting the path toward the ultimate evil act with a small, seemingly in- significant first step, the easy “foot in the door” that swings open subsequent greater compliance pressures, and leads down a slippery slope. (In the obedience study, the initial shock was only a mild 15 volts.) This is also the operative principle in turning good kids into drug addicts, with that first little hit or sniff.

- Having successively increasing steps on the pathway that are gradual, so that they are hardly noticeably different from one’s most recent prior action. “Just a little bit more.” (By increasing each level of aggression in gradual steps of only 15-volt increments, over the thirty switches, no new level of harm seemed like a noticeable difference from the prior level to Milgram’s participants.)

- Gradually changing the nature of the authority figure (the researcher, in Milgram’s study) from initially “just” and reasonable to “unjust” and demanding, even irrational. This tactic elicits initial compliance and later confusion, since we expect consistency from authorities and friends. Not acknowledging that this transformation has occurred leads to mindless obedience (and it is part of many “date rape” scenarios and a reason why abused women stay with their abusing spouses).

- Making the “exit costs” high and making the process of exiting difficult by allowing verbal dissent (which makes people feel better about themselves) while insisting on behavioral compliance.

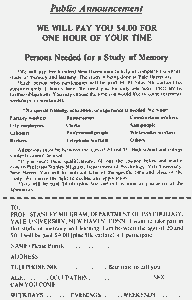

- Offering an ideology, or a big lie, to justify the use of any means to achieve the seemingly desirable, essential goal. (In Milgram’s research this came in the form of providing an acceptable justification, or rationale, for engaging in the undesirable action, such as that science wants to help people improve their memory by judicious use of reward and punishment.) In social psychology experiments, this tactic is known as the “cover story” because it is a cover-up for the procedures that follow, which might be challenged because they do not make sense on their own. The real-world equivalent is known as an “ideology.” Most nations rely on an ideology, typically, “threats to national security,” before going to war or to suppress dissident political opposition. When citizens fear that their national security is being threatened, they become willing to surrender their basic freedoms to a government that offers them that exchange. Erich Fromm’s classic analysis in Escape from Freedom made us aware of this trade-off, which Hitler and other dictators have long used to gain and maintain power: namely, the claim that they will be able to provide security in exchange for citizens giving up their freedoms, which will give them the ability to control things better.

Such procedures are utilized in varied influence situations where those in authority want others to do their bidding but know that few would engage in the “end game” without first being properly prepared psychologically to do the “unthinkable.” In the future, when you are in a compromising position where your compliance is at stake, thinking back to these stepping-stones to mindless obedience may enable you to step back and not go all the way down the path—their path. A good way to avoid crimes of obedience is to assert one’s personal authority and always take full responsibility for one’s actions.

Dieci lezioni dagli studi di Milgram: creare trappole di malvagità per brave persone

Vediamo di delineare alcune delle procedure di questo paradigma di ricerca che hanno indotto molti normali cittadini ad assumere una condotta in apparenza così grave. Nel far questo, voglio tracciare dei paralleli con le strategie di compiacenza usate da professionisti dell’influenza in situazioni reali, come venditori, reclutatori di sette e dell’esercito, pubblicitari, e così via. Ci sono dieci metodi che possiamo estrarre dal paradigma di Milgram per questo scopo:

- Predisporre qualche forma di obbligo contrattuale, orale o scritto, per controllare il comportamento dell’individuo in uno stile pseudolegale. (Nell’esperimento di Milgram, ciò veniva fatto con l’accordo esplicito ad accettare compiti e procedure.)

- Dare ai partecipanti dei ruoli significativi da interpretare (“insegnante”, “allievo”) che portano con sé dei valori positivi già noti in precedenza e che attivano automaticamente dei copioni di risposta.

- Presentare delle regole di base da seguire che sembrino aver senso prima di essere effettivamente usate, ma che possano poi essere impiegate arbitrariamente e in modo impersonale per giustificare una compiacenza meccanica. Inoltre, i sistemi controllano le persone rendendo le proprie regole vaghe e cambiandole secondo necessità, ma insistendo che “le regole sono regole” e quindi devono essere seguite (come faceva il ricercatore in camice da laboratorio nell’esperimento di Milgram, o le guardie dell’esperimento di Stanford per obbligare il prigioniero Clay-416 a mangiare le salsicce).

- Alterare la semantica dell’atto, dell’attore e dell’azione (da “far male alle vittime” a “aiutare lo sperimentatore”, punendo le suddette per il nobile traguardo della scoperta scientifica)—rimpiazzando la spiacevole realtà con una retorica apprezzabile, decorando la cornice in modo da nascondere il quadro reale. (Possiamo vedere la stessa inquadratura semantica al lavoro nella pubblicità, dove, per esempio, un collutorio dal cattivo sapore è mostrato come utile perché uccide i germi e ha il sapore che ci si aspetta da una medicina.)

- Creare opportunità per la diffusione di responsabilità o la sua abdicazione in caso di esiti negativi; altri saranno responsabili, o l’attore non dovrà risponderne. (Nell’esperimento di Milgram, la figura d’autorità diceva, di fronte ai dubbi dell'”insegnante”, che si sarebbe assunta la responsabilità per tutto ciò che accadeva all'”allievo”.)

- Iniziare il percorso verso l’atto malvagio finale con un piccolo passo apparentemente insignificante, il semplice “piede nella porta” che apre alle seguenti, e più grandi, pressioni per la compiacenza, e conduce giù per una brutta china. (Nello studio sull’obbedienza, lo shock iniziale era lieve, di soli 15 volt.) Questo è anche il principio operativo nel trasformare bravi ragazzi in tossicodipendenti, con quel primo piccolo buco o sniffata.

- Avere dei passi via via più grandi in modo graduale, così che siano difficilmente distinguibili dall’ultima azione eseguita. “Solo un altro po’.” (Aumentando gradualmente ciascun livello di solo 15 volt in più, lungo i 30 interruttori, per i partecipanti alla prova di Milgram nessun nuovo livello di danno sembrava differire in modo rilevante dal livello precedente.)

- Cambiare gradualmente la natura della figura di autorità (il ricercatore, nello studio di Milgram), all’inizio “giusto” e ragionevole, fino a “ingiusto” ed esigente, persino irrazionale. Questa tattica ottiene inizialmente compiacenza e successivamente confusione, dato che ci attendiamo da autorità e amici un comportamento coerente. Non riconoscere il verificarsi di questa trasformazione porta all’obbedienza automatica (ed è parte di molti scenari di stupri da parte di nuove conoscenze, e una ragione per cui le donne vittime di abusi rimangono con i coniugi che abusano di loro.)

- Rendere i “costi di uscita” alti e rendere difficile il processo di uscita permettendo il dissenso verbale (facendo sentire meglio le persone riguardo alla propria responsabilità) insistendo al contempo sulla compiacenza nei comportamenti.

- Offrire un’ideologia, o una grande bugia, per giustificare l’uso di ogni mezzo per raggiungere il traguardo apparentemente desiderabile ed essenziale. (Nella ricerca di Milgram ciò avveniva nella forma di una giustificazione accettabile, o ragione, per partecipare ad un’azione indesiderabile, come il fatto che la scienza vuole aiutare le persone a migliorare la propria memoria con un uso giudizioso di ricompensa e punizione.) Negli esperimenti di psicologia sociale, questa tattica è nota come “la copertura” delle procedure, che potrebbero essere contestate in quanto di per sé prive di senso. L’equivalente nel mondo reale è nota come “ideologia”. La maggior parte delle nazioni si affidano ad un’ideologia, tipicamente, “minacce per la sicurezza nazionale”, prima di andare in guerra o per sopprimere l’opposizione politica e il dissenso. Quando i cittadini temono che la loro sicurezza nazionale sia minacciata, accettano di consegnare le loro libertà fondamentali ad un governo che offre uno scambio di questo tipo. La classica analisi di Erich Fromm in Fuga dalla libertà ci ha reso consapevoli di questo compromesso che Hitler e altri dittatori hanno a lungo usato per raggiungere e conservare il potere: nello specifico, l’affermazione che sarebbero stati in grado di fornire sicurezza in cambio della rinuncia, da parte dei cittadini, delle libertà, in modo da poter controllare meglio le cose.

Procedure simili sono utilizzate in varie situazioni basate sull’influenza dove le autorità vogliono che gli altri facciano la loro scommessa ma sanno che pochi parteciperebbero al “gioco finale” senza prima essere adeguatamente preparati psicologicamente a commettere “l’impensabile”. In futuro, quando vi trovate in una posizione compromettente dove è in gioco la vostra compiacenza, ripensare a questi passi verso l’obbedienza cieca può consentirvi di fare un passo indietro e non seguire fino in fondo il percorso—il loro percorso. Un buon modo per evitare crimini di obbedienza è sostenere la propria autorità personale e assumersi sempre la piena responsabilità per le proprie azioni.

(Philip Zimbardo, The Lucifer Effect: Understanding How Good People Turn Evil, 2007)